Primero necesitamos crear un archivo de cabecera (.h) que contendrá todos los samples de nuestro audio.

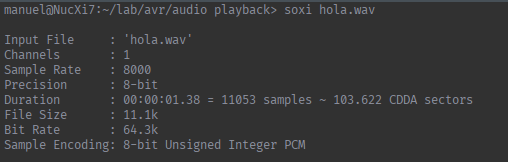

El archivo de audio que necesitamos tiene que tener las siguientes caracteristicas:

- Formato .wav

- Mono (1 solo canal)

- 8000 samples por segundo (8000hz)

- Samples codificados como 8 bits unsigned

Para comprobar las caracteristicas de un archivo podemos usar el comando soxi del paquete sox:

soxi audio.wav

La salida es algo como esto:

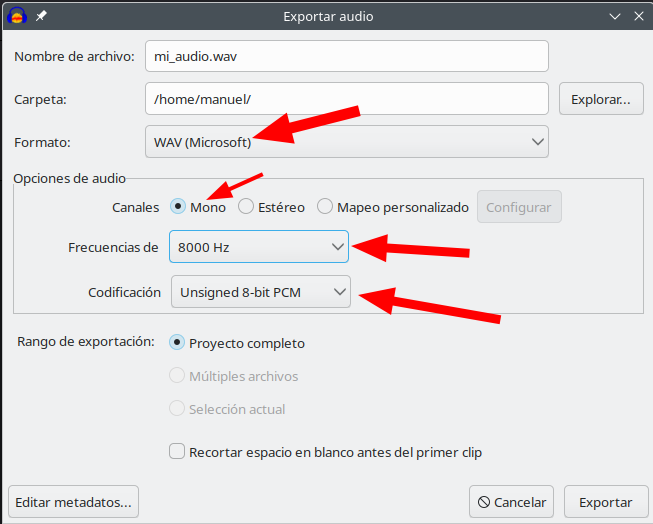

Si nuestro audio no tiene los parametros correctos, podemos convertirlo usando Audacity, solo tenemos que re-exportar el audio asi:

Una vez tenemos el audio con los parámetros necesarios generamos el archivo de cabecera con los samples, usando el siguiente script de python:

import wave

import sys

def getWaveData(waveFile):

try:

w = wave.Wave_read(waveFile)

data = []

for i in range(w.getnframes()):

data.append(int.from_bytes(w.readframes(1)))

return(data)

except FileNotFoundError:

print("No existe el archivo indicado")

exit()

def createHeader(filename, waveData):

outfile = open(filename[:-4] + ".h", "w")

outfile.write('const uint8_t wave_audio[] PROGMEM = {\n')

for sample in waveData:

outfile.write(' {:d},\n'.format(sample))

outfile.write('};\n')

outfile.close()

if __name__ == "__main__":

if len(sys.argv) == 1:

print("\nERROR: indica un archivo, eg: python " + sys.argv[0] + " audio.wav\n")

exit()

filename = sys.argv[1]

waveData = getWaveData(filename)

createHeader(filename, waveData)

Para ejecutar el script solo tenemos que pasarle el archivo .wav como primer argumento:

python WaveToArray.py hola.wav

El script nos generará un archivo .h como el siguiente:

const uint8_t wave_audio[] PROGMEM = {

130,

122,

116,

111,

107,

101,

97,

94,

94,

99,

114,

132,

154,

168,

173,

166,

150,

133,

120,

...

...

...

(Samples omitidos por brevedad)

}

Cada linea es un sample del audio, y ocupa 1 byte, por lo tanto el numero de lineas que tenga el array es el tamaño del audio en memoria, (para el atmega168pa no debería de ser mayor de 16.000 lineas (16KB))